Recentemente, os produtos de IA generativa têm chamado muita atenção, inclusive nos setores sem fins lucrativos e de impacto social. Essas tecnologias oferecem o potencial de otimizar operações, reduzir tarefas administrativas e ampliar o impacto para comunidades atendidas. No entanto, seus efeitos a longo prazo permanecem incertos. Na condição de fornecedor de tecnologia que apoia organizações sociais, acreditamos ser essencial abordar a IA de forma responsável, garantindo um desenvolvimento ético, uma implementação robusta e o bem-estar dos usuários finais e beneficiários.

Navegar pelo potencial da IA significa lidar com um cenário complexo de considerações éticas, sociais e regulatórias. Antes de discutir como as organizações sociais podem guiar e avaliar suas iniciativas de IA, é importante reconhecer desafios como vieses, preocupações com privacidade e políticas comerciais ou de vigilância. Reconhecer esses fatores fornece um contexto importante para construir soluções de IA responsáveis que realmente sirvam ao bem público, respeitando as normas locais e os valores da comunidade.

Os fornecedores de tecnologia frequentemente destacam os benefícios da IA: processos otimizados, análise de dados aprofundada e potencial economia de custos. Enquanto isso, órgãos globais, regionais e nacionais estão desenvolvendo estruturas para garantir que a IA seja usada de forma segura e ética. Entre as mais influentes estão os Princípios de IA da Organização para a Cooperação e Desenvolvimento Econômico (OCDE), amplamente reconhecidos por orientar a governança responsável da IA, e a estrutura de políticas da União Europeia, baseada em direitos humanos, que enfatiza a transparência e a responsabilidade.

No Brasil, a discussão é liderada pelo Projeto de Lei 2338/2023, que, após aprovação no Senado, busca na Câmara dos Deputados criar um marco legal para a IA centrado no respeito aos direitos humanos e na classificação de riscos.

Em algumas regiões, contudo, as políticas nacionais podem priorizar metas comerciais ou de vigilância em detrimento dos direitos humanos, ressaltando a necessidade de defesa contínua e de um diálogo global sobre a IA responsável.

Este artigo não é um guia exaustivo nem um manual completo de melhores práticas. Em vez disso, ele oferece nossas reflexões e as principais lições de meses avaliando soluções de IA especificamente para o contexto de organizações sem fins lucrativos. À medida que introduzimos funcionalidades de IA em nossos produtos, permanecemos focados em garantir que elas realmente beneficiem as organizações de impacto social e as comunidades vulneráveis que elas atendem. Nosso objetivo é equipar os líderes de tecnologia de ONGs com passos práticos, perguntas e recursos para adotar a IA de forma responsável.

Este artigo convida você a fazer uma pausa e avaliar criticamente a IA antes de adotá-la. As perguntas que usamos internamente guiam nosso pensamento sobre impacto social, mitigação de riscos e alinhamento com as melhores práticas éticas.

“Ao avaliar um caso de uso para uma ferramenta de IA, precisamos considerar o custo de oportunidade de implementar essa solução. Não podemos ser movidos pelo desejo de digitalizar por digitalizar; em vez disso, precisamos manter o foco nas pessoas que estamos tentando ajudar e, onde houver valor na IA, cabe a nós, tecnólogos, provar esse valor.”

– Bilal Mateen (Diretor de IA) – PATH

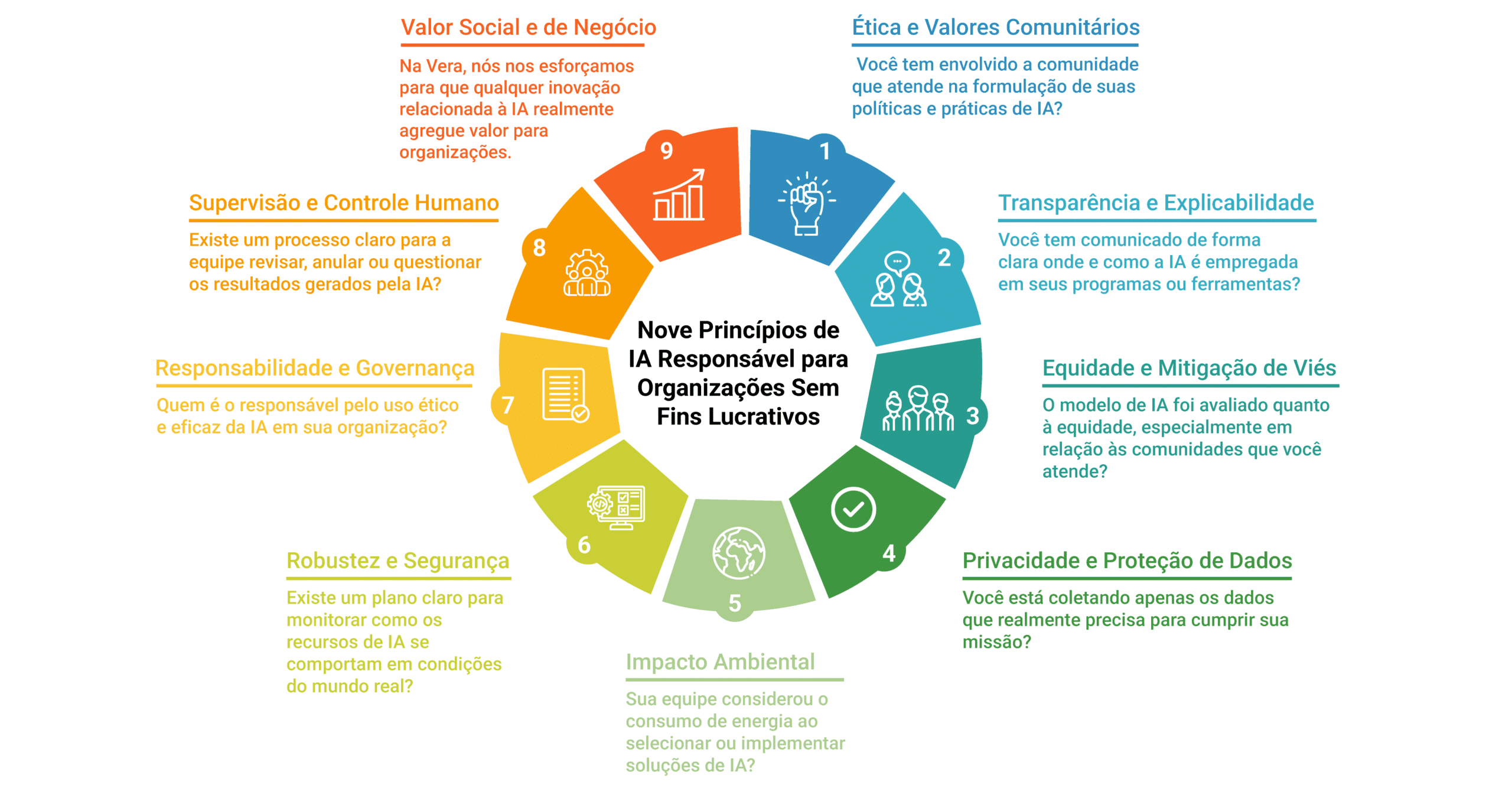

1. Ética e Valores Comunitários

Ética não é um conceito universal, especialmente no setor de impacto social. Qualquer estrutura ética para IA deve ser contextual, refletindo as normas sociais, perspectivas culturais e princípios éticos das comunidades atendidas por uma determinada ONG. Ao envolver as partes interessadas — beneficiários, equipe, líderes locais e parceiros — é fundamental que as organizações garantam que suas soluções de IA honrem esses valores, promovam a confiança e permaneçam relevantes para o contexto local.

Reflita:

- Você tem envolvido os beneficiários que atende na formulação de suas políticas e práticas de IA?

- Sua abordagem de IA sustenta e respeita as normas sociais e os preceitos éticos locais?

- Como essas normas podem variar entre diferentes regiões ou grupos de beneficiários?

2. Transparência e Explicabilidade*

Ser transparente sobre como a IA é usada e torná-la compreensível para as partes interessadas são dois pilares essenciais da IA ética e responsável. Em um contexto de impacto social, essa clareza é especialmente importante, pois a confiança forma a base dos relacionamentos com doadores, beneficiários e parceiros.

Reflita:

- Você tem comunicado de forma clara onde e como a IA é empregada em seus programas ou ferramentas?

- As decisões que a IA toma podem ser explicadas em termos que a equipe, os beneficiários ou os doadores consigam entender?

Na Vera, apoiamos inúmeras fundações e doadores em sua missão de direcionar seus recursos de forma eficaz. Quando a IA é usada, por exemplo, para fazer recomendações sobre candidaturas a grants, a explicabilidade ajuda as partes interessadas a entender por que uma proposta específica é bem avaliada ou sinalizada para revisão. Essa clareza não apenas constrói confiança, mas também garante que decisões importantes de financiamento sejam baseadas na equidade.

*Explicabilidade é uma área da inteligência artificial focada em criar sistemas que não sejam uma “caixa-preta”. O objetivo é que a IA seja capaz de justificar suas decisões e responder de forma compreensível à pergunta: “Por que você chegou a este resultado?”

3. Equidade e Mitigação de Viés

No setor de impacto social, vieses não intencionais na IA podem ter consequências reais para comunidades marginalizadas. O viés surge quando os dados usados para treinar a IA refletem desigualdades históricas ou sistêmicas, ou quando os modelos de IA favorecem inadvertidamente certos grupos em detrimento de outros.

Reflita:

- O modelo de IA foi avaliado quanto à equidade, especialmente em relação às comunidades que você atende?

- Existem processos em vigor para reduzir o viés potencial em seus dados ou algoritmos?

Por exemplo, uma ONG pode usar IA para analisar pedidos de assistência habitacional de beneficiários. Se os dados subjacentes vierem de uma região historicamente mal atendida ou sub-representada, o modelo poderia, inadvertidamente, ignorar certos candidatos. Ao verificar regularmente os resultados da IA e corrigir as discrepâncias — talvez usando ferramentas como Error Analysis e o Fairlearn — as organizações podem minimizar esses danos não intencionais.

4. Privacidade e Proteção de Dados

Lidar com dados sensíveis é uma preocupação central para muitas ONGs, pois elas frequentemente trabalham com informações pessoais de voluntários, doadores ou beneficiários. Em iniciativas impulsionadas por IA, manter a privacidade vai além do compliance básico; demonstra respeito pelas pessoas cujos dados estão sendo usados.

Reflita:

- Você está coletando apenas os dados que realmente precisa para cumprir sua missão?

- Dados sensíveis são anonimizados ou criptografados quando apropriado?

- Você está seguindo as regulamentações de privacidade relevantes como a LGPD?

Manter os dados dos beneficiários seguros contra o uso indevido é primordial por razões tanto éticas quanto práticas. A confiança é central na relação entre as ONGs e as comunidades que atendem, e mesmo pequenas falhas de privacidade podem minar essa confiança.

5. Impacto Ambiental

Embora as ONGs geralmente operem com recursos mais enxutos em comparação com empresas comerciais, os modelos de IA ainda podem consumir uma quantidade substancial de energia, especialmente durante o treinamento. Com a sustentabilidade ambiental sendo uma alta prioridade na agenda de muitas organizações, é prudente refletir sobre como a adoção da IA pode afetar sua pegada de carbono.

Reflita:

- Sua equipe considerou o consumo de energia ao selecionar ou implementar soluções de IA?

- Existem opções para usar modelos menores e mais eficientes, caso atendam às suas necessidades?

- Seu provedor de infraestrutura está comprometido em reduzir a própria pegada ambiental?

O progresso na medição da pegada ambiental da IA está em andamento. A colaboração da Salesforce com Hugging Face, Cohere e a Universidade Carnegie Mellon em um AI Energy Score oferece uma maneira de avaliar quais modelos podem ser mais eficientes, ajudando assim as organizações sociais a se manterem atentas à sustentabilidade. Quando se trata de pegada ambiental, nem todos os modelos de linguagem são criados iguais. Modelos de Linguagem Pequenos e especializados (Small Language Models), por exemplo, têm uma pegada muito menor do que Modelos de Linguagem Grandes e genéricos (Large Language Models) como o Chat-GPT-4, que exigem um poder significativo de GPU/TPU para operar.

6. Robustez e Segurança

As organizações de impacto social frequentemente operam com restrições de recursos e, por isso, a necessidade de uma tecnologia robusta e segura se torna ainda mais evidente. As soluções de IA devem ser resilientes a erros e ameaças externas, desde violações de dados até o uso indevido de modelos preditivos.

Reflita:

- Existe um plano claro para monitorar como a IA se comporta em condições reais?

- Você está preparado para lidar com falhas de sistema ou uso indevido, especialmente de maneiras que possam prejudicar os beneficiários?

De acordo com a OCDE, garantir a rastreabilidade e a gestão de riscos em sistemas de IA pode ajudar as ONGs a lidar com possíveis problemas de forma mais eficaz. Isso também fortalece a confiança na tecnologia perante parceiros e financiadores.

7. Responsabilidade e Governança

A responsabilidade garante que as soluções de IA estejam alinhadas com a missão e os valores de uma organização ao longo de todo o seu ciclo de vida. Isso envolve estabelecer linhas claras de responsabilidade e estruturas de governança para manter a supervisão e enfrentar desafios.

Reflita:

- Quem é responsável pelo uso ético e eficaz da IA em sua organização?

- Existe um protocolo ou uma equipe dedicada a revisar as decisões geradas pela IA e lidar com possíveis erros?

A norma ISO/IEC 42001 oferece às ONGs uma estrutura de avaliação de risco para a governança de IA. Embora mais formal, ela pode ser adaptada para se ajustar ao tamanho e escopo de uma organização, garantindo que a responsabilidade permaneça como prioridade máxima.

8. Supervisão e Controle Humano

As ferramentas de IA devem servir para aprimorar, e não substituir, a expertise e a compaixão humanas, marcas registradas do setor sem fins lucrativos. Seja com assistentes sociais na linha de frente usando análises de previsão para identificar comunidades com maior necessidade, profissionais de saúde usando ferramentas de apoio à decisão alimentadas por IA, ou equipes de desenvolvimento analisando ou automatizando o engajamento de doadores, o julgamento humano é indispensável.

Reflita:

- Existe um processo claro para a equipe revisar, anular ou questionar os resultados gerados pela IA?

- A equipe e os voluntários são adequadamente treinados para interpretar as recomendações da IA?

Ao manter a supervisão humana, as ONGs podem garantir que as decisões permaneçam alinhadas à missão e eticamente fundamentadas, mesmo quando assistidas por tecnologias avançadas.

9. Valor Social e de Negócio

Na Vera, nós nos esforçamos para que qualquer inovação relacionada à IA realmente gere valor para organizações sociais. Nossas principais lições para ONGs que buscam aproveitar a IA de forma responsável incluem:

- Não adote a IA apenas por ser a nova tendência. Identifique onde a IA pode genuinamente aliviar a carga de trabalho da equipe, acelerar processos importantes ou impulsionar a execução de projetos.

- A qualidade dos dados é fundamental. A IA depende da integridade dos dados de entrada, então certifique-se de que seus dados sejam precisos, representativos e bem organizados.

- Comece pequeno e teste. Projetos-piloto e Provas de Conceito (Proof of Concepts) podem revelar desafios imprevistos antes de um lançamento em larga escala.

Adoraríamos colaborar com organizações dedicadas a maximizar o impacto social da IA. Se você tem interesse em soluções de IA responsáveis e sustentáveis, entre em contato conosco pelo email ai@verasolutions.org.